با عرض سلام و احترام خدمت شما کاربران محترم وبسایت دکتر آکادمی.با یکی دیگر از مقالات خوب و ویژه آموزش ایجاد فایل robots txt به صورت جامع و کاربردی در حدمت شما عزیزان هستم.احتمالا سوالاتی مثل محتوای فایل robots txt چیست؟ یا تاثیر فایل robots.txt در سئو و همینطور کاربرد فایل robots.txt در ذهن شما است.پس با من همراه باشید تا بتوانیم این فایل را به صورت کاربردی بررسی کنیم.

بریم؟؟ 🙂

این فایل,یک نوع فایل متنی است که به ربات های گوگل دستور میدهد که چه آدرس هایی را ایندکس کنند و همینطور چه ادرس هایی را انیدکس نکنند.

نکته ای که بد نیست بدانید این اسن که این فایل ربطی به نوع سیستم مدیریت محتوا شما ندارد.

ربات های گوگل قبل از اینکه به سایت شما مراجعه کنند به این فایل میروند تا ببینند که شما چه دستور العملی به آنها داده اید.پس این موضوع حیاتی است و ممکنه با یک اشتباه به سایت خود لطمه بزنید.

نمونه فایل گوگل : robots.txt

نحوه ساخت robots txt

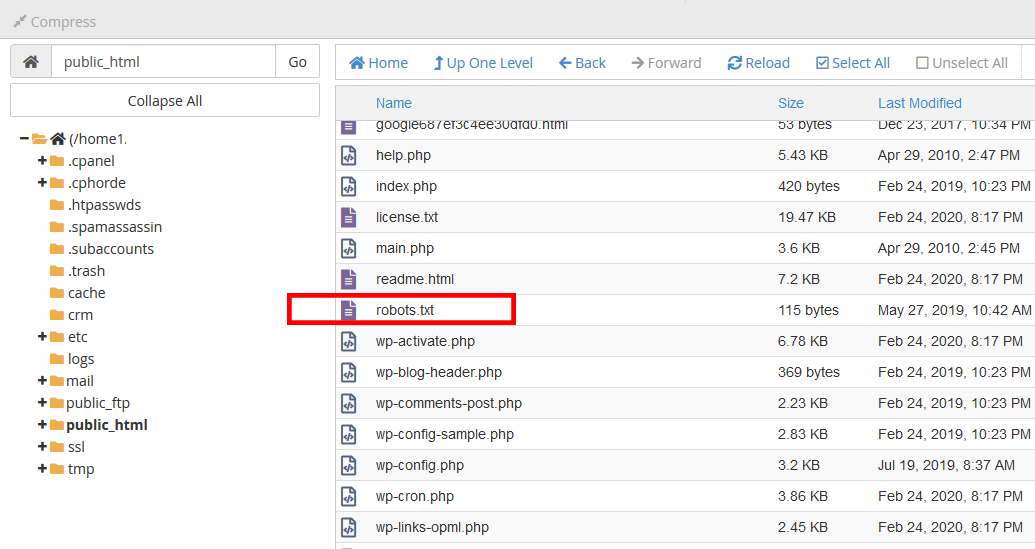

در دامنه خود به این آدرس مراجعه کنید : http://domain.com/robots.txt اگر این آدرس را پیدا نکردید یعنی این فایل دستور را ندارید و باید اقدام به ساخت این فایل در هاست خود کنید.به قسمت public_html هاست خود مراحعه کنید و یک فایل متنی ایجاد کنید بنام robots.txt .

خودِ گوگل هم در مقاله ای جهت راهنمایی ایجاد این فایل به شما کمک کرده : create robots

اولین گزینه ای که باید قرار بدهید

- User-agent : در روبروی این دستور باید نام ربات مورد نظر گوگل را بنویسید.برای اینکه تمامی ربات ها را شامل شود از دستور * استفاده میکنیم.

- Disallow : مقابل این دستور باید دایرکتوری هایی را بنویسید که قرار نیست ربات های گوگل آنها را ایندکس کنند.” در کوچک و بزرگ نوشتن حروف مراقب باشید چون ربات های گوگل نسبت به حروف دایرکتوری ها حساس هستند”

- Allow : این دستور کاملا برعکس دستور قبلی است.

حالا بریم سراغ چند مثال :

گزینه اول :

User-agent: * Disallow: /

در دستور اول به گوگل اعلام میکنیم که شامل تمامی ربات ها شود.با علامت * مشخص کرده ایم و در دستور دوم با علامت / مشخص کرده ایم که شامل کل آدرس های دامنه ما میباشد و هیچ ربات دستور خزش و ایندکس سایت ما را ندارد.

گزینه دوم:

User-agent: *

Disallow:

در این دستور دقیقا بر عکس دستور بالا است و تمامی ربات های گوگل مجوز خزش و ایندکس سایت ما را دارند.

مثال کاربردی تر : 🙂

گزینه سوم :

User-agent: googlebot

Disallow: /blog

در این دستور به ربات گوگل(googlebot) میگوییم که قسمت بلاگ سایت ما را ایندکس نکن(Blog) و هر آدرسی مربوط به قسمت بلاگ باشد ایندکس نمیشود.

نکته: سایر ربات ها اجازه دسترسی دارند به سایت ما به جز ربات گوگل!

گزینه چهارم:

همچنین شما میتوانید از Regular Expression یا عبارات منظم برای دستورات خود استفاده نمایید.به عنوان مثال دستور دهید که پسوند مورد نظری که در فایل روت هاست من در پوشه test میباشد را ایندکس نکن.

User-agent: * Disallow: /test/*.pdf

ساخت فایل robots.txt در وردپرس

گزینه پنجم :

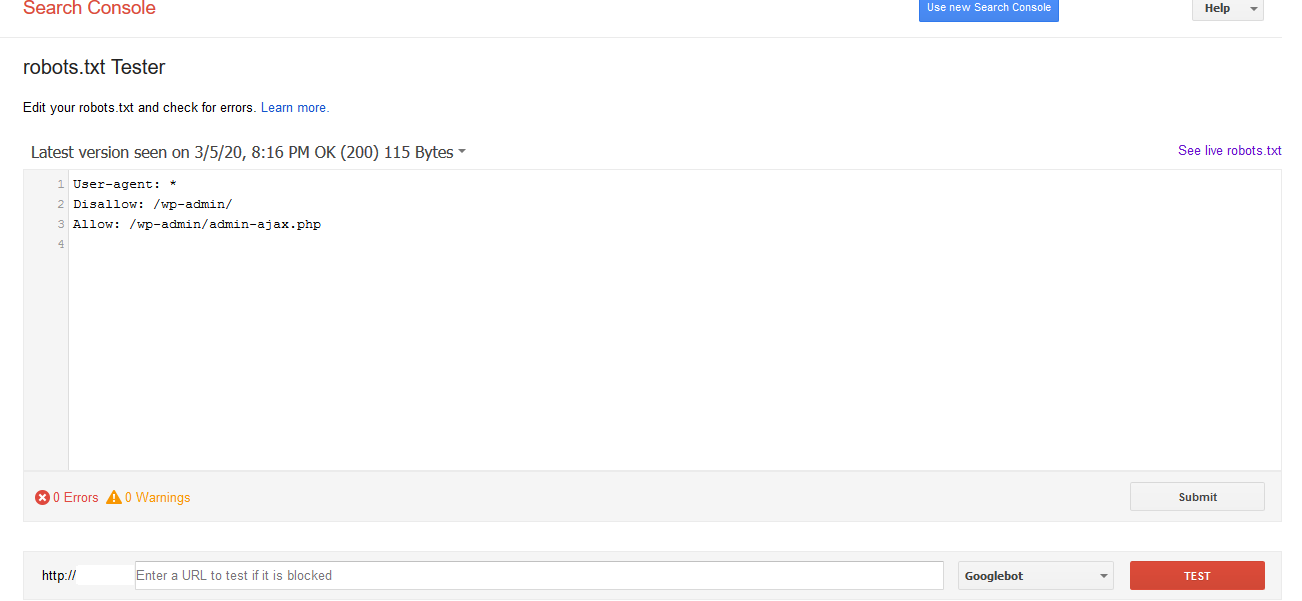

دستور مشابهی در اکثر سایت های وردپرسی وجود دارد که اجازه دسترسی به فایل wp-admin را به ربات ها نمیدهند ولی به فایل admin-ajax.php که در پوشه

wp-admin را ایندکس کنند.مانند کد زیر:

User-agent: * Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

گزینه ششم:

در برخی از سایت هایی که دچار مشکل فنی میشوند,آدرس هایی با علامت ؟ منتشر میشوند.برای جلوگیری از این خطا ها میتوانید از دستور زیر استفاده کنید :

User-agent: * Disallow: /*?* برای مثال های بیشتر میتوانیداز منبع گوگل استفاده کنید :Google example

مرحله آخر : تست فایل ساخته شده

پس از ساخت این فایل میتوانید به ادرس robots.txt Tester مراجعه کنید و فایل خودتان را تست کنید.

امیدوارم این مقاله در جهت بهبود سایت شما مفید واقع شده باشد.سوالات خودتان را میتوانید زیر همین مقاله برایمان ارسال کنید و در کمترین زمان پاسخگو شما عزیزان خواهم بود.

با احترام-حسین آقاجانی